Generatieve AI inzetten kan wél verantwoord (en ethisch)

Open State biedt hulp – lees hier hoe 👇

- Workshops ter bevordering van de verplichte AI-literacy;

- Presentaties voor raadsleden, ambtenaren en lokale bestuurders over AI;

- Hulp bij de keuze van AI-model en verantwoording over de inzet;

- Begeleiding van impact assessments zoals het IAMA;

- Toetsing van de effectiviteit van uw transparantie over de inzet van algoritmes en AI;

- Demo van onze verantwoorde AI-tool, chat.Bron.

Waarom is transparantie nodig voor verantwoorde inzet?

In de afgelopen jaren is duidelijk geworden dat de opkomst van generatieve AI niet meer te stuiten is. De algehele milde paniek die ontstond over wat voor impact AI zou gaan hebben op het dagelijks leven, het bedrijfsleven en de overheid lijkt voorbij. Ondertussen zijn we een heleboel te weten gekomen en kunnen we feiten beter scheiden van (science-)fictie. Open State deed in 2023 en 2024 onderzoek naar de potentiële impact van generatieve AI op de democratie in ons project Debot. En in augustus 2024 trad de AI-act (getrapt) in werking.

AI-modellen zijn getraind op grote hoeveelheden data.

Transparantie over deze data is echter ver te zoeken. De grote techbedrijven willen niet vertellen welke data gebruikt is en hoe hierin is geselecteerd en welke data ‘beter’ was dan andere. Het belang hiervan komt voort uit het effect dat optreedt tijdens fundamentele training. Er ontstaat in het model een balans, een representatie van de werkelijkheid op een wiskundige wijze. Deze balans is behoorlijk robuust maar kan beïnvloed worden door goede data vaker te gebruiken in de training. Bij fundamentele training geldt: “wat het model niet gezien heeft in de training, dat ‘kent’ het niet”. Daarom worden bij de training ook bijvoorbeeld racistische, misogyne en anderzins ‘foute’ teksten meegenomen. Doordat de ‘goede’ teksten vaker langskomen zal het model gaan herkennen wat goed en slecht is. Bij finetuning kan daarbij nog bijgestuurd worden indien het model dit niet zelf heeft herkend.

? Maar wie bepaalt wat ‘goed’ en wat ‘slecht’ is? Dat hangt heel erg af van de normen en waarden van het datateam en dus uit welk land het datateam komt.

AI modellen bevatten bias.

Voor AI-deskundigen is dit duidelijk een foute statement. AI is per definitie namelijk een algoritme dat onderscheid maakt – bias is het hele eieren eten. Wat we hier bedoelen is dat er ongewenste onderscheiden (bias) op basis van kenmerken in AI-modellen zitten. Hier liggen meerdere redenen aan ten grondslag. De meest bekende reden is: Er zit bias in de data. Als je ruwe AI in zou zetten voor het selecteren van de beste mensen voor een positie als manager dan zouden er meer witte mannen uitrollen. De data is tenslotte een representatie van het verleden en het heden en daarin zijn witte mannen oververtegenwoordigd. Dit zou je tegen kunnen gaan door een vangrail (guardrail) in te bouwen – dit is een soort spelregel – die zegt dat de uitkomst 50-50 man-vrouw zou moeten zijn. Zo’n spelregel moet je dan toevoegen voor elk kenmerk waarop je diversiteit wil zien in het eindresultaat.

! De andere, meer onbekende, reden is dat AI niet menselijk is. Zo bleek uit een studie in 2022 dat AI op basis van medische scans ‘ras’ kon herkennen van de patiënten zonder hun (externe) foto’s te zien. Hierdoor zie je dat AI onderscheid kan maken op basis van kenmerken die voor een mens niet duidelijk zichtbaar zijn. Zo zit er dus ongewenste bias in AI die er ook niet makkelijk uit te halen is en waar je het systeem op zult moeten testen om erachter te komen.

Toelichting op de diensten die Open State u kan bieden

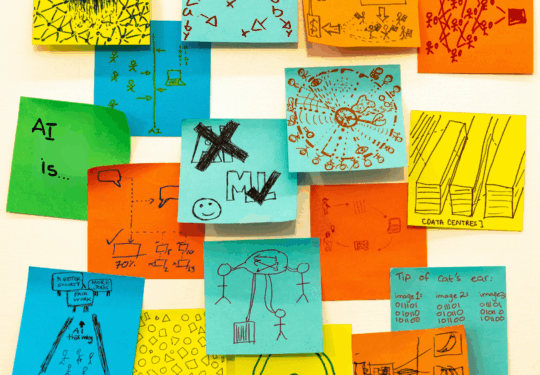

Workshops ter bevordering van AI-literacy

In deze workshop van 6 uur wordt de werking van generatieve AI uitgelegd op het noodzakelijke niveau. De AI-act vereist dat je AI-systemen op een verstandige, veilige en kritische manier kunt gebruiken. Dit betekent dat je afhankelijk van jouw rol in de organisatie een andere kennisniveau zult moeten hebben.

Wij bieden kennis aan tot op het hoogste niveau van AI-developer. Maar ook voor de ‘gewone gebruiker’ hebben we workshops om beter en verantwoord AI te gebruiken.

De prijs voor deze workshop start vanaf € 4.500,-

Presentaties voor raadsleden (en andere politici) en bestuurders

Informatie over generatieve AI die aangeboden word is vaak afkomstig van de AI-bedrijven zelf of van diegenen die AI-diensten aan willen bieden. In deze presentatie bieden wij onafhankelijke en actuele informatie over AI, zowel de kansen als de risico’s. Als onafhankelijke stichting hebben wij geen belang bij de keuzes die gemaakt worden na de presentatie. Wij combineren juridische, bestuurskundig en technische kennis tot een begrijpelijk verhaal waar je echt wat aan hebt.

Uiteraard maken we de presentatie graag op maat, zo kunnen we hem aanpassen van 45 minuten tot 3 uur. Hierbij zijn er ook opties voor het toevoegen van interactie en lokale context.

De prijs voor deze presentatie start al vanaf € 450,-

Hulp bij de keuze van AI-modellen en verantwoording over de inzet van AI

Met onze praktische ondersteuning stomen we uw organisatie klaar om zelf aan de slag te gaan en kunt u voldoen aan de nieuwe wet- en regelgeving rondom AI.

Transparantie is geen doel op zich maar het middel om te komen tot verantwoorde inzet van AI. Transparant zijn over de inzet van AI is zeer goed mogelijk en dat is het makkelijkste vanaf de start van het proces, maar ook bij algoritmes en AI die reeds in productie zijn kunnen wij helpen. De werkwijze die wij hanteren in dit proces is er op gericht om alle (deel-)producten te publiceren. Dat betekent dat er niet achteraf nog gelakt hoeft te worden als er een Woo-verzoek komt of als de inzet actief geopenbaard wordt.

Onze aanpak is gebaseerd op het 5-sterrenmodel voor transparante algoritmes omdat dit ook (met een paar kleine aanpassingen door ons) in te zetten is voor generatieve AI. Wij adviseren op strategisch niveau over de doelstellingen en het na te streven ambitieniveau. Daarnaast helpen wij met de ethische toetsing en geven we in dit proces ook een critical review van het proces, van ontwikkeling tot en met publicatie. Met deze producten kunt u uw processen verbeteren en compliant aan de AI-act en Nederlandse wet- en regelgeving handelen.

Ons ondersteuningsproces maken wij volledig op maat voor u, de prijs is daarom variabel. Het proces bestaat uit ten minste de volgende onderdelen:

- Bestuurlijke sessie

- Ethische sessie voor ambtenaren

- Critical review van het ontwikkel en publicatie proces

- Eindrapportage met aanbevelingen

Begeleiding van impact assessments

Een impactassessment uitvoeren, zowel voor de inzet van algoritmes als AI, is een uitgebreid proces waarbij domeinexperts, ontwikkelaars, beleidsmakers en bestuurders betrokken moeten worden. Voor het uitvoeren van de IAMA bestaan er handreikingen hoe je het proces in kunt richten, maar de praktijk toont aan dat dit alsnog niet makkelijk is. Daarom bieden we vanuit Open State een pakket aan met begeleiding door een van onze multi-disciplinaire experts. Wij combineren juridische en bestuurskundige kennis en ervaring met diepgaande technische kennis.

Met onze hulp kunt u daarnaast het eindproduct, de impact assessment publiceren, omdat deze voldoet aan alle vereisten én zorgvuldig wordt opgesteld door ons. Hiermee kunt u de registratie van het algoritme aanvullen en aan uw klanten laten zien dat u zorgvuldig te werk gaat.

Het begeleiden van een IAMA vergt drie sessies van elk drie uur met deelnemers uit alle betrokken afdelingen en lagen van uw organisatie (niet iedereen is bij elke sessie aanwezig). De prijs voor de begeleiding start voor een algoritme van gemiddelde complexiteit vanaf € 5.500,- Dat is inclusief een rapportage die geschikt is voor publicatie.

Toetsing van de effectiviteit van transparantie

Het gebruik van algoritmes en AI kent een voordelen. Ze kunnen patronen herkennen die mensen over het hoofd zien en doen dat ook nog zonder moe te worden. Daardoor kunnen algoritmes bijdragen aan efficiëntie, rechtszekerheid en schaalbaarheid.

Naast deze grote positieve effecten schuilen er ook risico’s in de toepassing van algoritmes en AI. Keuzes die een programmeur maakt bij het ontwerpen van het systeem kunnen vergaande, onbedoelde, gevolgen hebben. Evenals de effecten van bias in traingsdata of het ontbreken van goede controle en herstel processen. Automation bias is tot slot nog een groot risico; we moeten waken voor het verwerkelijke van de uitspraak ━ “computer says no”. Er is vaak beperkt zicht op de risico’s, dat is onaanvaardbaar. Het openbaren van het systeem gaat ook gepaard met een interne check of alles ‘ok’ is. Openbaarheid draagt op die manier bij aan betere systemen, een goede reden om transparant te zijn dus.

De grote uitdaging bij het openbaar maken van algoritmes is om effectief te doen. Daar hebben wij bij Open State ruime ervaring mee. Wij werkten reeds voor het algoritmeregister van Amsterdam en adviseerden over het algoritmeregister van Justid.

“Mr. M Bakker, algemeen directeur Justid — Het rapport (red. van Open State) geeft waardevolle inzichten over hoe Justid nog beter kan voldoen aan de informatiebehoefte over (hoog risico) algoritmes in de samenleving. Er zijn nog echte verbetermogelijkheden. Dit rapport biedt hierbij goede ondersteuning. U heeft de aanbevelingen onder meer met behulp van een burgerpanel concreet en toepasbaar in het rapport op een rij gezet.”